De Groeiende Ecologische Voetafdruk van AI

Generatieve AI heeft in korte tijd een enorme gebruikersbasis opgebouwd met toepassingen zoals ChatGPT voor gesprekken, Stable Diffusion voor het maken van afbeeldingen en Suno voor muziekgeneratie. Het succes van deze tools is deels te danken aan hun gebruiksvriendelijke interfaces, maar die verbergen de complexe infrastructuur die erachter schuilgaat. Zoals Sam Altman, CEO van OpenAI (het bedrijf achter ChatGPT), het verwoordt: ’feels like magic’. De realiteit is echter dat deze tools enorme hoeveelheden energie, water en mineralen verbruiken, wat resulteert in een aanzienlijke uitstoot van broeikasgassen.

not gpt-5, not a search engine, but we’ve been hard at work on some new stuff we think people will love! feels like magic to me.

— Sam Altman (@sama) May 10, 2024

monday 10am PT. https://t.co/nqftf6lRL1

Het proces van AI-ontwikkeling gebruikt natuurlijke grondstoffen in verschillende stappen: de ontginning van grondstoffen, de productie van de serverinfrastructuur, de ontwikkeling van het model, het gebruik ervan, en uiteindelijk de afvalverwerking. De ecologische voetafdruk van veel van deze stappen blijft onduidelijk door de complexiteit van de processen en beperkte transparantie van bedrijven. Het meeste onderzoek richt zich op de ontwikkeling en het gebruik van AI-modellen, aangezien deze fasen beter meetbaar zijn.

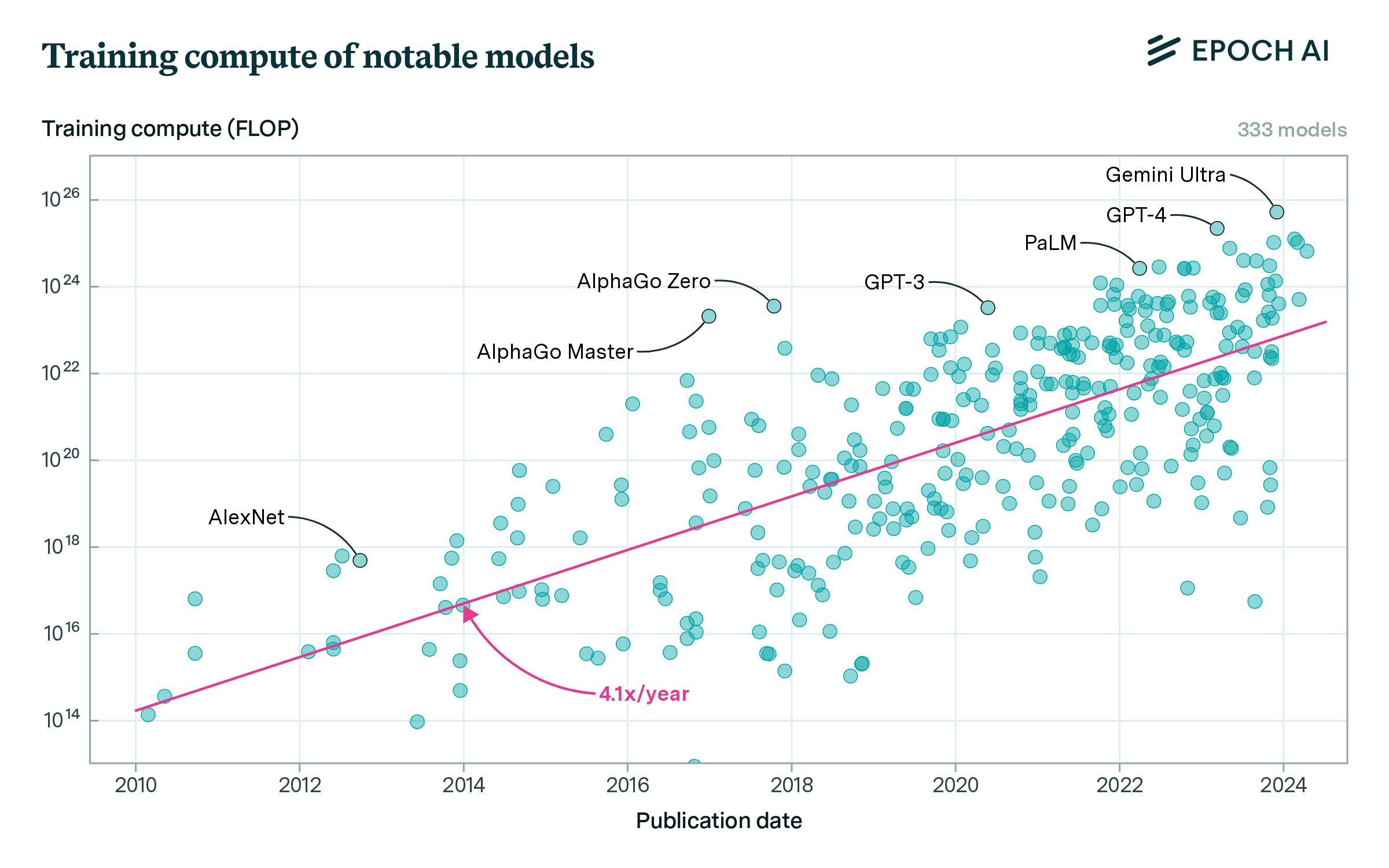

Gedreven door de schalingswetten worden AI-modellen almaar groter. Deze empirische wetten stellen dat meer data, parameters en computerkracht leiden tot betere nauwkeurigheid. Als gevolg hiervan zijn de modellen de afgelopen jaren exponentieel gegroeid, met een steeds grotere behoefte aan rekenkracht. In de grafiek van Epoch AI hieronder zien we voor verschillende modellen het aantal benodigde FLOPS voor de ontwikkeling. Een FLOP, wat staat voor Floating Point Operation, is een elementaire computerberekening.

Het uitvoeren van al deze FLOPs vereist enorme hoeveelheden energie. Hoewel er over de meeste modellen weinig informatie beschikbaar is, biedt GPT-3 een interessant inzicht. Dit OpenAI-model uit 2020, met 175 miljard parameters dat de eerste versie van ChatGPT mogelijk maakte, verbruikte 1.287 MWh en stootte 552 ton CO2 uit tijdens zijn ontwikkeling. Dit energieverbruik staat gelijk aan wat 500 Vlaamse gezinnen jaarlijks verbruiken, terwijl de CO2-uitstoot overeenkomt met die van 120 benzineauto’s per jaar. De nieuwere modellen overtreffen deze cijfers ruimschoots: GPT-4 telt naar schatting 1,8 biljoen parameters, terwijl Gemini Ultra van Google nog eens aanzienlijk groter zou zijn.

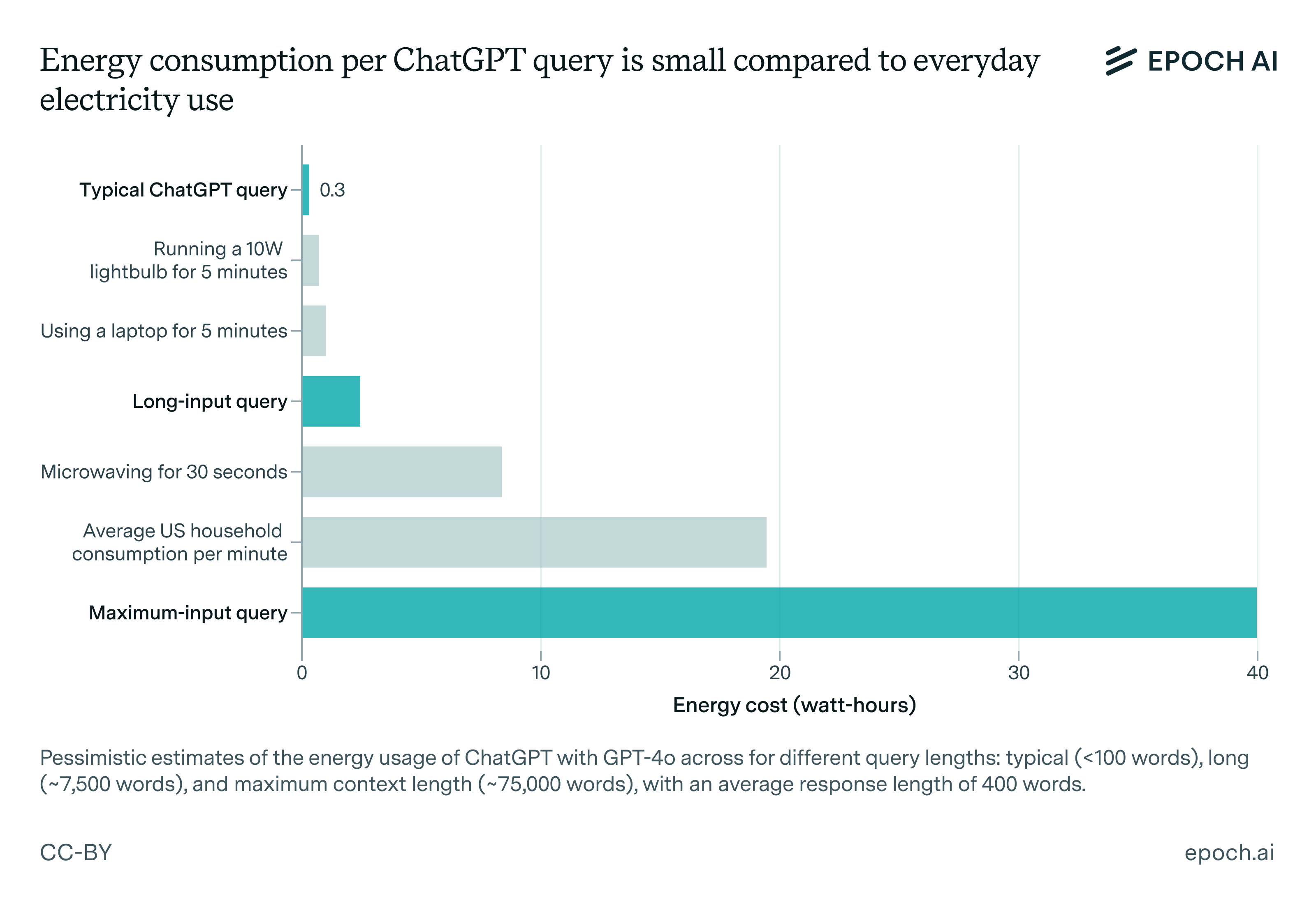

Zodra een AI-model ontwikkeld is, begint het pas echt: het gebruik ervan wat nog meer energie verbruikt dan de ontwikkeling. Bij ChatGPT, met zijn miljoenen dagelijkse gebruikers, overtreft het energieverbruik voor gebruik al na enkele weken dat van de training. Google geeft aan dat een vraag via hun AI-model het bedrijf 10 keer meer kost dan een traditionele Google-zoekopdracht. Een typische ChatGPT-vraag verbruikt ongeveer 0,3 wattuur. Dit is minder dan een LED-lamp of laptop gedurende enkele minuten maar varieert wel sterk met de lengte van de vraag (zie onderstaande figuur van Epoch AI). De impact wordt pas echt duidelijk in de totaalsom: OpenAI heeft wekelijks meer dan 400 miljoen gebruikers die dagelijks meer dan een miljard berichten versturen. OpenAI is bovendien niet de enige aanbieder: er zijn ook Claude van Anthropic, Gemini van Google en nog vele andere zoals het Chinese Deepseek – dat in januari ChatGPT zelfs onttroonde als populairste app in zowel de Android Play Store als de iPhone App Store. AI wordt ook steeds vaker geïntegreerd in andere toepassingen, zoals Kate, de AI-assistente van KBC. Het energieverbruik verschilt sterk per taak, waarbij taken met afbeeldingen meer energie vergen. Zo is de energiekost van het genereren van één afbeelding vergelijkbaar met het opladen van een smartphone (220 wattuur).

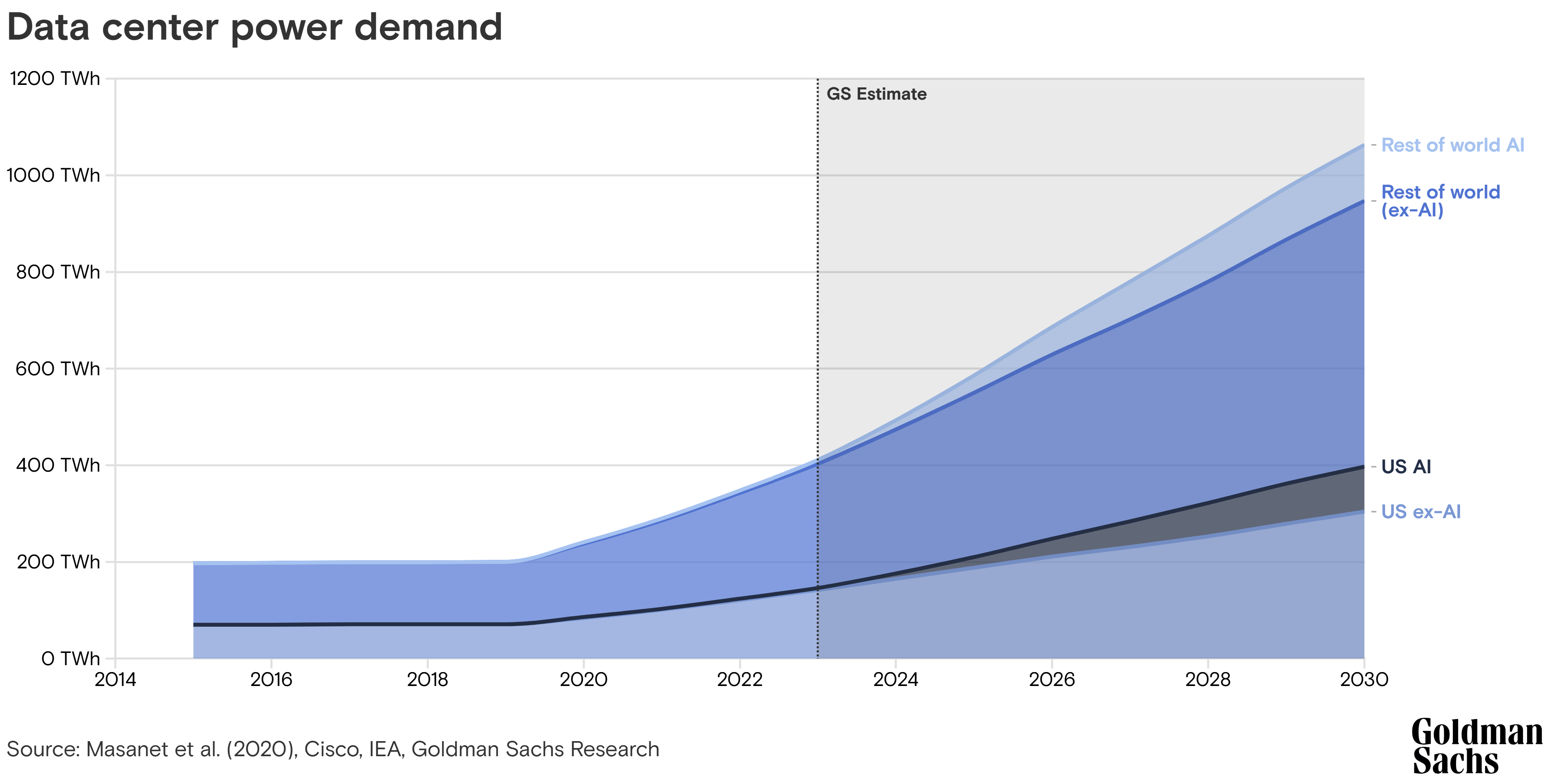

Het geschatte wereldwijde elektriciteitsverbruik van datacenters in 2022 was 240-340 TWh, ongeveer 1-1,3% van de mondiale finale elektriciteitsvraag. In 2020 stonden datacenters en de transmissie van data in voor 0,6% van de totale uitstoot van broeikasgassen, vergelijkbaar met de totale uitstoot van de luchtvaartindustrie. Deze datacenters worden natuurlijk niet enkel gebruikt voor AI-toepassingen en er wordt geschat dat AI momenteel instaat voor 10-20% van het gebruik, maar dit percentage stijgt snel (zie figuur van Goldman Sachs hieronder).

Minder dan de helft van de energie die een datacenter verbruikt, gaat naar het voeden van de servers. Een aanzienlijk deel wordt gebruikt voor koeling. Net zoals een laptop tijdens gebruik warm wordt en een ventilator nodig heeft voor koeling of serverruimtes actief gekoeld worden door speciale airco’s. Voor datacenters volgepakt met servers vormt koeling een significante uitdaging: zo’n 30 à 40% van de totale energie gaat hiernaartoe. Dit koelproces vereist grote hoeveelheden water om warmte af te voeren, waarvan een aanzienlijk deel verdampt. Onderzoek schat dat GPT-3, het AI-model achter ChatGPT, 500ml water verbruikt voor elke 10 tot 50 vragen (al ligt dit voor de nieuwere modellen waarschijnlijk 4 keer hoger).

De enorme energiebehoefte van AI-systemen heeft ervoor gezorgd dat verschillende grote technologiebedrijven zoals Microsoft en Google hun klimaatdoelstellingen niet halen en de vooropgestelde reductie in broeikasgassen niet bereiken. Deze bedrijven zoeken nu naar alternatieve oplossingen om alsnog hun klimaatambities waar te maken zoals het gebruik van groene stroom uit hernieuwbare energie om datacenters te voeden. IJsland is hierdoor een aantrekkelijke locatie geworden voor datacenters: het land beschikt over uitgebreide mogelijkheden voor geothermische en hydroelektrische energie, en door het koude klimaat is er minder energie en water nodig voor koeling. Dit heeft echter ook een keerzijde. Zo vragen milieuactivisten zich af of dit wel een goede besteding van energie is en of deze niet beter gebruikt kan worden voor IJsland zelf.

Een andere optie waar de technologiebedrijven in investeren is kernenergie. Hoewel dit een oplossing biedt voor de uitstoot van broeikasgassen, brengt het andere uitdagingen met zich mee, zoals de verwerking van radioactief afval en veiligheidsrisico’s. Een voorbeeld is Microsoft’s overeenkomst om de kerncentrale Three Mile Island in Pennsylvania te heropenen, een centrale die bekend staat om een gedeeltelijke nucleaire meltdown in 1978.

Enkele bedrijven gaan nog verder door datacenters in de ruimte te ontwikkelen, zoals het Europese Ascend en het Amerikaanse Starcloud. De ruimte biedt twee belangrijke voordelen: ononderbroken toegang tot zonne-energie en natuurlijke koeling door de extreme kou. Voorlopig blijft dit echter science fiction, aangezien het lanceren van de benodigde apparatuur niet rendabel is, ook al dalen deze kosten dankzij bedrijven zoals SpaceX gestaag.

Voor de productie van AI-servers zijn verschillende metalen nodig waarvan de ontginning grote ecologische schade veroorzaakt. Sommige van deze metalen, zoals kobalt en wolfraam, zijn conflictmineralen die uit conflictgebieden komen. De ontginning en handel van deze mineralen dragen bij aan mensenrechtenschendingen en gewapende conflicten.

De energiehonger van AI-toepassingen blijft onverminderd groeien. De Amerikaanse president Donald Trump kondigde direct na zijn inauguratie het Stargate project aan, een ambitieus plan met een geplande investering van 500 miljard dollar in AI-datacenters. Op de AI Action top in Parijs presenteerde de Franse president Emmanuel Macron de overcapaciteit aan kernenergie als Franse troef. Waar volgens hem de VS het motto “drill, baby, drill” hanteert, is het in Frankrijk “plug, baby, plug”. Het Chinese Deepseek bewees dat efficiëntere AI-systemen mogelijk zijn, wat een schokgolf door de AI- en financiële wereld stuurde. De langetermijnimpact blijft echter onduidelijk. Volgens Jensen Huang, de CEO van chipmaker NVIDIA, zal de vraag naar servers hierdoor zelfs verder toenemen.

Er ontbreken nog veel gegevens voor een volledig beeld van de ecologische voetafdruk van AI. Dit geldt bijvoorbeeld voor informatie over de productie van servers en het industrieel afval van datacenters, dat risico’s voor het milieu met zich meebrengt. Daarnaast kan het gebruik van AI voor efficiëntieverbeteringen in vervuilende sectoren paradoxaal genoeg leiden tot meer vervuiling, zoals bij de exploratie van olie en gas. Daarnaast draagt AI infrastructuur bij aan de groeiende berg e-waste, volgens schattingen tot wel 5 miljoen ton in 2030.

De uitdagingen rond de ecologische impact van AI vereisen een breed maatschappelijk debat. Technologische vooruitgang hoeft niet ten koste te gaan van het milieu, maar dit vraagt om doordachte keuzes en innovatieve oplossingen. Bedrijven, overheden en consumenten moeten samenwerken om de energietransitie te versnellen en duurzame alternatieven te ontwikkelen. Alleen door de milieukosten volledig mee te rekenen in de ontwikkeling van AI-systemen, kunnen we ervoor zorgen dat artificiële intelligentie bijdraagt aan een duurzame toekomst in plaats van deze te ondermijnen.

Vond je deze post interessant?

Dan zijn deze misschien ook iets voor jou! 👇