AI als bewaker van fort Europa

De inzet van AI voor grensbewaking en immigratiecontrole is een snel groeiende toepassing van deze technologie. Europa investeert miljarden in de ontwikkeling en implementatie van AI-systemen die moeten helpen bij het monitoren en controleren van migratie. Deze ontwikkeling roept belangrijke ethische en praktische vragen op over effectiviteit, mensenrechten en discriminatie.

AI wordt veelvuldig toegepast voor surveillance. Bedrijven zoals Amazon gebruiken algoritmisch management om werknemers te monitoren en hun productiviteit automatisch te beoordelen. Bij ondermaatse prestaties kan dit zelfs leiden tot automatisch gegenereerde ontslagbrieven. China zet grootschalige surveillance in, vooral bij de onderdrukking van de Oeigoerse minderheid in de Xinjiang-regio. Ook de VS heeft fors geïnvesteerd in deze technologie voor grenscontrole en het opsporen van mensen zonder papieren.

Ook Europa zet de laatste jaren sterk in op AI-technologie voor grensbewaking. Dit moet leiden tot kortere verwerkingstijden en minder handmatig werk voor ambtenaren. De totale EU-begroting voor grenzenbeleid is met 94% gestegen vergeleken met de vorige periode (2014-20) waarvan een aanzienlijk deel bestemd is voor digitale technologieën. Mensenrechtenorganisaties bekritiseren deze systemen vanwege hun gebrek aan transparantie en omdat ze fundamentele rechten bedreigen zoals privacy, non-discriminatie, eerlijk proces en het vermoeden van onschuld.

Bij het inzetten van AI-toepassingen voor zulke gevoelige domeinen rijzen er steeds zorgen over de rechtvaardigheid van deze systemen. De algoritmes zijn slechts zo goed als de data waarmee ze worden gevoed, en helaas is neutraliteit geen sterke eigenschap van de mens, iets wat zich weerspiegelt in de data die we genereren. Dit heeft al tot verschillende schandalen geleid, zoals het COMPAS systeem dat Amerikaanse rechters hielp bij het bepalen van het risico op recidive, maar systematisch een hoger risico toekende aan mensen met een gekleurde huidskleur. Een ander bekend voorbeeld is de seksistische recruiteringstool van Amazon, die bij het automatisch scannen van cv’s vrouwen standaard een lagere score gaf. Deze vooroordelen sluipen vaak zo subtiel in de systemen dat ze pas worden ontdekt als het systeem al in gebruik is.

Migratie is een complex beleidsterrein waarbij de overheid via verschillende processen ingrijpt. Het rapport van het Algorithmic Fairness and Asylum Seekers and Refugees (AFAR) Project categoriseert deze AI-toepassingen in drie fasen: voor aankomst, bij aankomst en na aankomst. Hieronder bespreken we enkele voorbeelden samen met de uitdagingen. Deze bespreking is zeker niet volledig, zie bijvoorbeeld het genoemde rapport voor meer voorbeelden.

Voor aankomst wordt AI reeds ingezet bij de automatische verwerking van visumaanvragen. Het Britse Home Office gebruikte hiervoor een tool die aanvragen automatisch in drie categorieën sorteerde: groen, oranje of rood. De precieze werking van dit algoritme werd niet gedeeld werd. We weten wel dat nationaliteit een van de beoordelingscriteria was. Verschillende mensenrechtenorganisaties bekritiseerden dat het systeem hierdoor een “snelle boarding voor witte mensen” creëerde. Dit leidde tot het stopzetten van de tool. Nederland gebruikt een vergelijkbaar systeem dat visumaanvragen automatisch beoordeelt op basis van onder andere nationaliteit, leeftijd en geslacht. De Data Protection Officer (DPO) van het betrokken agentschap heeft dit systeem al meerdere keren als potentieel discriminerend aangemerkt.

Bij aankomst aan de grens kennen de meeste mensen AI van de automatische paspoortcontrole op luchthavens. Hierbij wordt gezichtsherkenning gebruikt om te controleren of een passagier overeenkomt met de persoon op het paspoort. Voor extra betrouwbaarheid worden soms ook irisscans ingezet. De technologie blijkt echter niet feilloos, zoals bleek uit een ‘fiasco’ op de Brusselse luchthaven. Het systeem slaagde er vaak niet in een match te maken, waardoor de beoogde efficiëntiewinst uitbleef. In één geval liet het systeem zelfs een vrouw door die het paspoort van haar man had gescand. Een andere toepassing op luchthavens zijn camera’s die passagiers scannen en via gezichtsherkenning controleren of er mensen aanwezig zijn die op een ‘zwarte lijst’ staan. Dit gebeurde op de luchthaven van Brussel, grotendeels buiten het zicht van het publiek, totdat het werd stilgelegd wegens het ontbreken van een juridische basis voor het aanleggen van een biometrische database met gezichtsafbeeldingen.

Aan de grens experimenteert men met AI-toepassingen die doen denken aan de dystopische Netflix-serie Black Mirror. Deze worden vaak gefinancierd met Europese subsidies voor onderzoek die bedoeld zijn voor civiele toepassingen, zoals het Horizon-programma. Een voorbeeld is het ROBORDER project, dat een volledig autonoom grensbewakingssysteem ontwikkelt met onbemande robots voor lucht, water en land. Een nog controversiëler voorbeeld is het iBorderCtrl project. Dit systeem beoordeelt de non-verbale communicatie van reizigers, zoals gezichtsuitdrukking, blik en houding, om te bepalen of zij liegen. Reizigers moeten voor hun reis online vragen beantwoorden van een virtuele grenswacht. Hun reacties worden via de webcam geanalyseerd en beoordeeld op waarheidsgetrouwheid. Bij een hoge ‘leugen-score’ volgt extra onderzoek door grensofficieren. Het project ontving veel kritiek. Zo toonde onderzoek aan dat het systeem nauwkeuriger is voor Europese mannen dan voor vrouwen en niet-Europeanen. Bovendien staat de onderliggende aanname dat je uit een opname kan bepalen of iemand liegt wetenschappelijk op losse schroeven. Dit sluit aan bij een breder probleem waarbij AI wordt ingezet voor emotiedetectie, terwijl de wetenschap de effectiviteit hiervan betwijfelt. Een verwant controversieel project is TRESSPASS, dat voortbouwt op iBorderCtrl en onderzoekt hoe geautomatiseerde gedragsanalyse kan worden toegepast tijdens interviews met grenswachters.

Tot slot wordt AI ook ingezet in het aankomstland. Letland maakt bijvoorbeeld gebruik van automatische spraakherkenning als onderdeel van hun burgerschapsprocedure via het ‘Speak the Anthem’ project. Kandidaten kunnen deze technologie gebruiken om hun uitspraak en kennis van het Letse volkslied te testen, wat een vereiste is voor het verkrijgen van burgerschap. Hoewel de tool niet volledig accuraat is, dient deze alleen als hulpmiddel tijdens het oefenen. De uiteindelijke beoordeling van de uitvoering van het volkslied gebeurt door menselijke beoordelaars.

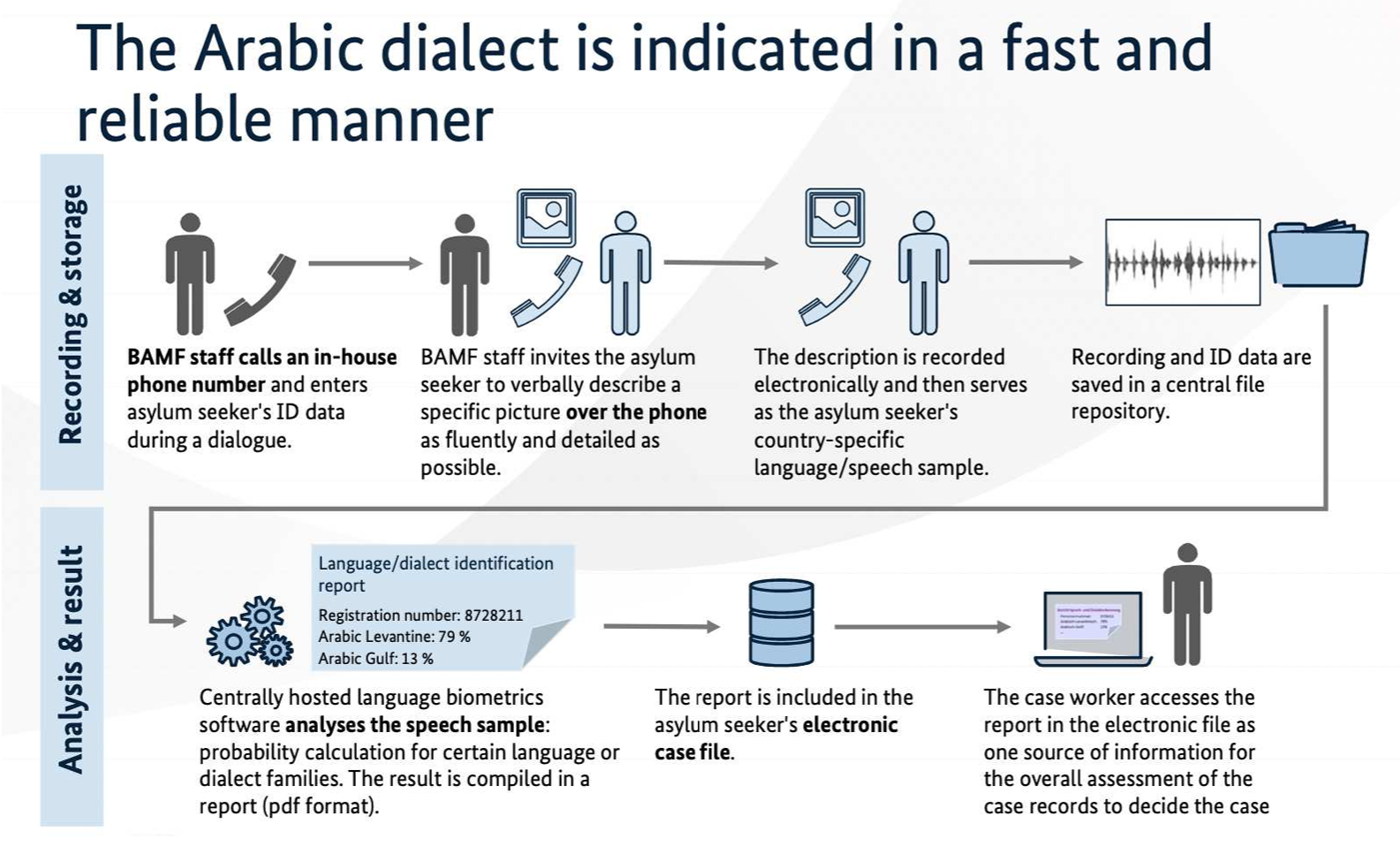

Op andere plaatsen wordt spraaktechnologie minder vrijblijvend ingezet. In Duitsland maakt men als onderdeel van de asielprocedure gebruik van het dialect identificatie assistentie systeem (DIAS). Dit systeem gebruikt AI om talen en dialecten te detecteren van asielzoekers. Het DIAS-systeem analyseert een spraakopname en geeft waarschijnlijkheidspercentages voor verschillende talen (bijvoorbeeld 60% Levantijns Arabisch, 20% Golf-Arabisch, 5% Turks, etc.). Deze resultaten worden toegevoegd aan het asieldossier en kunnen dienen als bewijsmateriaal bij fraudeonderzoek of als bewijsmateriaal voor herkomstlanden voor de terugname van uitgeprocedeerde asielzoekers.

Er zijn ernstige vragen over de betrouwbaarheid van deze tool, die door de autoriteiten op 80% werd geschat, al gaven ze aan dat verdere verbetering gepland was. Taalkundigen benadrukken dat het onmogelijk is om met absolute zekerheid een dialect te bepalen. Mensen passen hun spraak immers aan afhankelijk van hun gesprekspartner. Bovendien zijn taal en zeker dialecten dynamisch en constant in verandering. Dit betekent dat de spraakdataset waarop de algoritmes zijn gebaseerd steeds minder relevant wordt en regelmatig zou moeten worden bijgewerkt. Hoewel deze technologie duidelijke tekortkomingen heeft, verschaft ze de autoriteiten wel een modern imago als technologische pionier. Zo werd de DIAS-tool binnen het openbaar bestuur zelfs uitgeroepen tot beste digitaliseringsproject in 2018.

Deze voorbeelden tonen aan dat AI-systemen niet volledig betrouwbaar zijn en kunnen leiden tot discriminatie. Vorig jaar trad de Europese AI Act in werking om de risico’s van AI-toepassingen aan te pakken en een juridisch kader te scheppen voor betrouwbare implementatie. Deze treedt stapsgewijs in werking, met een eerste fase begin februari (zie ook Eerste stap van de AI Act. Binnenkort allemaal AI geletterd?) en het grootste deel in augustus 2026. Wat betreft het gebruik van AI-technologieën voor immigratie-, asiel- en grensbewakingsdoeleinden valt in de AI Act vooral het gebrek aan bescherming voor migranten op. Hoewel de wet automatische emotieherkenning verbiedt wegens gebrek aan wetenschappelijke basis, geldt dit niet voor migratie waardoor bijvoorbeeld het gebruik van AI-leugendetectors aan de grenzen wordt toegestaan. De AI Act is verder alleen van toepassing op systemen die Europese burgers beïnvloeden, niet op Europese bedrijven die AI-tools ontwikkelen voor mensen buiten de EU. Bovendien wordt voor grootschalige IT-systemen van de EU die migrantendata verwerken, zoals Eurodac, het Schengeninformatiesysteem en ETIAS, de AI Act pas in 2030 bindend. Mensenrechtenorganisaties protesteren hiertegen onder de slogan EU #Protect Not Surveil. Ze pleiten voor een verbod op experimentele technologie tegen grensoverschrijders en dringen aan op effectieve regelgeving die veilig en controleerbaar AI-gebruik garandeert.

Eind 2023 werd nieuwe Europese wetgeving voorgesteld om op te treden tegen het smokkelen van migranten. Dit bevat een voorstel om de werking van de Europese grensorganisatie Frontex sterk te integreren met de Europese politiedienst Europol waarbij lidstaten verplicht worden data te delen over vluchtelingen. Het doel zou zijn om beter te kunnen optreden tegen illegale smokkelaars maar volgens mensenrechtenorganisaties is het in de praktijk vooral data van de vluchtelingen en hulpverleners die door de politiediensten zullen worden opgevolgd. Mensenrechtenorganisaties argumenteren dat het net dit soort maatregelen zijn die vluchtelingen in de handen van illegale smokkelaars duwen.

De toenemende inzet van AI-technologie voor grensbewaking en migratiecontrole in Europa illustreert een belangrijk spanningsveld tussen technologische innovatie en mensenrechten. Hoewel deze systemen efficiëntiewinst beloven, blijken ze in de praktijk vaak onbetrouwbaar en discriminerend. De nieuwe AI Act biedt weliswaar een regelgevend kader, maar laat belangrijke hiaten bestaan in de bescherming van migranten. De recente voorstellen voor nauwere samenwerking tussen Frontex en Europol lijken deze trend voort te zetten, waarbij de focus ligt op surveillance en controle in plaats van humanitaire bescherming. Deze ontwikkelingen roepen fundamentele vragen op over de balans tussen veiligheid en mensenrechten, en de rol die AI zou moeten spelen in het Europese migratiebeleid.

Vond je deze post interessant?

Dan zijn deze misschien ook iets voor jou! 👇